Realistische virtuelle Umgebungen machen die Optimierung von Experimenten in vielen Wissenschaftsbereichen möglich.

Noch lange sind nicht alle Abläufe in der hochkomplexen “Maschine Mensch” vollständig erforscht. Vor allem die Funktionsweise von Gehirn und Sinneswahrnehmungen stellt Forschende noch vor Rätsel. Erst vor Kurzem erhielten David Julius und Ardem Patapoutian den Nobelpreis für Medizin für die Entdeckung von Rezeptoren für Temperatur und Druck. Das zeigt, dass sogar grundlegende Funktionsweisen des menschlichen Körpers noch nicht vollständig erforscht wurden.

Ein anderes Beispiel zeigt sich in lauten Umgebungen, etwa in einer Bahnhofshalle. Wie ist es hier möglich, sich voll auf das Gespräch mit dem Gegenüber zu konzentrieren, obwohl die Ohren alle Umgebungsgeräusche erfassen? Diese Frage fällt in den Forschungsbereich „Auditive Wahrnehmung“, in dem die Prozesse erforscht werden, mit denen das Gehirn die Klangwelt interpretiert. Er untersucht zudem die Wahrnehmung komplexer Geräusche (was entscheidend für die Verarbeitung von Sprache, Musik und Umgebungsgeräuschen ist) und die dafür verwendeten Gehirnareale. Bisher war es hierbei schwer, chaotische Umgebungen wie Bahnhöfe in einer kontrollierten Laborumgebung zu simulieren. Virtual-Reality (VR)-Technologien sind Forschenden dabei schon länger eine große Hilfe.

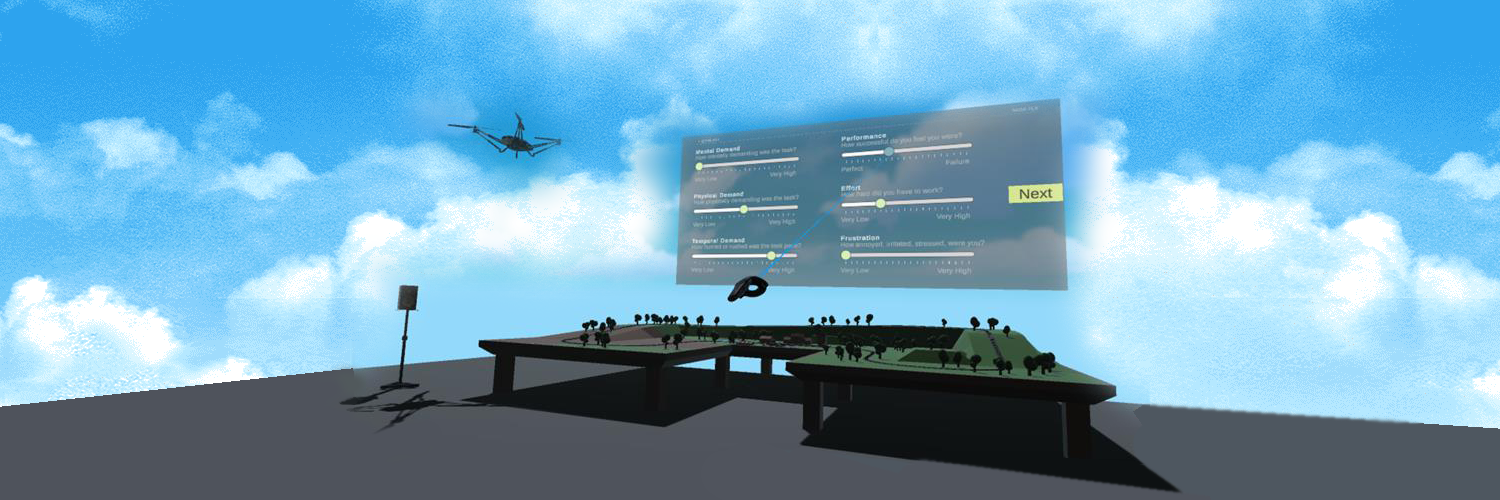

In den letzten Jahren wurden beträchtliche Fortschritte beim Verständnis auditiver kognitiver Prozesse und Fähigkeiten erzielt. Dabei kamen in Experimenten einfache virtuelle Umgebungen zum Einsatz. Diese sind zwar gut kontrollierbar, aber oft unrealistisch. Die jüngsten Entwicklungen bringen VR-Technologien sehr nahe an die Realität heran. So können viele Einschränkungen früherer Laborumgebungen überwunden werden. Beispielsweise tragen interaktive virtuelle Umgebungen (Interactive Virtual Environments, IVE) dazu bei, die auditive Wahrnehmung komplexer audiovisueller Situationen zu verstehen. Sie können für die Modellierung akustisch ungünstiger Situationen verwendet werden; etwa für den eingangs geschilderten Bahnhof, aber auch für laute Klassenzimmer oder volle Großraumbüros.

Wie evaluiert man das Virtuelle?

Eine extrem überzeugende virtuelle Umgebung macht die Technologie transparent und Menschen können ganz natürlich mit der virtuellen Welt interagieren. Doch wie bewertet man die Qualität von IVEs und welche Referenzgrößen sind hierfür relevant? In der klassischen Audio- und Videocodierung ist die Qualitätskontrolle vergleichsweise simpel: Gängige Praxis ist der direkte Vergleich von codierten und nicht-codierten Signalen. Dabei konzentriert man sich auf einen bestimmten Aspekt (wie Ton-oder Bildqualität) und schaltet zwischen Original und zu bewertendem Signal hin und her. Hierbei fallen Unterschiede schnell auf. Diese Methode ist für IVEs oft nicht geeignet. Da diese multimodal sind und sogar Bewegungen in der virtuellen Szene erlauben, betrachtet man automatisch mehr als einen Aspekt (Ton, Bild, Bewegung). Diese multimodale sensorische Stimulation hat signifikante Auswirkungen auf Aufmerksamkeit und Qualitätsbewertung.

Um solche Lücken in der Methodik zu finden und zu schließen, wurde das von der Deutschen Forschungsgemeinschaft (DFG) geförderte Projekt „Quality of Experience Evaluation of Interactive Virtual Environments with Audiovisual Scenes“ (QoEVAVE) ins Leben gerufen. Es untersucht auch, ob man aus dem Verhalten von Menschen in einem IVE auf dessen Qualität schließen kann. Das Projekt basiert auf Erkenntnissen der Quality-of-Experience (QoE)-Forschung und erweitert diese um Ansätze aus dem VR-Bereich, um den ersten umfassenden QoE-Rahmen für IVEs zu entwickeln. Das Ziel ist eine integrierte Sicht auf die Wahrnehmung der IVE-Qualität als kognitiven Prozess und auf die kognitive Leistung bei bestimmten Aufgaben als Merkmal für die Qualität eines IVE.

Mit vereinten Kräften Wissenschaft vorantreiben

Prof. Dr. ir. Emanuël Habets von den International Audio Laboratories (AudioLabs) Erlangen und Prof. Dr.-Ing. Alexander Raake von der TU Ilmenau leiten die Forschung im QoEVAVE Projekt. Gemeinsam erarbeiten und testen ihre Teams in einem mehrstufigen Prozess eine Methode, mit der die Qualität der IVE evaluiert werden kann. Diese Methode soll sowohl unimodal (es wird immer nur ein Stimulus – Audio oder Video – bewertet) als auch multimodal (es werden zwei oder mehr Stimuli zusammen bewertet) funktionieren. Der erste Schritt ist die Erarbeitung eines unimodalen Testverfahrens. Dazu wird eine 360 Grad Bild- und Tonaufnahme von einer Alltagssituation gemacht. Die Medienprofis der TU Ilmenau sind dabei für die Videoaufnahme zuständig, während sich die Audioexperten der AudioLabs um die Audioaufnahme (mit einem em32 Eigenmike) und das binaurale Rendering der Aufnahmen kümmern. In dieser Szene können Probanden nur den Kopf bewegen (3 Degrees of Freedom, 3DoF). Durch die echte Videoaufnahme und die einschränkten Bewegungsmöglichkeiten können sich die Testpersonen entweder auf die Audio- oder die Videoqualität konzentrieren. Die letzte Projektstufe ist die Evaluierung in einer vollständig virtuellen Szene, in der man sich frei bewegen kann (6 DoF). Spannend ist dabei zum Beispiel die Frage, ob die Testpersonen die gleiche Audioqualität in beiden Szenen unterschiedlich beurteilen. Gängige Bewertungsmethoden, wie ein MUSHRA-Test, sind bei der Bewertung von IVEs nicht direkt anwendbar. Daher entwickeln die Forschenden aus Erlangen und Ilmenau existierende Evaluierungsplattformen weiter und passen sie an virtuelle Umgebungen an.

QoEVAVE ist Teil des 3-jährigen Koordinierten DFG-Programms AUDICTIVE (Auditory Cognition in Interactive Virtual Environments, http://www.spp2236-audictive.de), das im Januar 2021 startete. AUDICTIVE bringt Forscher aus Akustik, kognitiver Psychologie und Informatik/ Virtueller Realität zusammen. Ziel ist ein genaueres Verständnis der auditiven Wahrnehmung mit Hilfe von interaktiven virtuellen Umgebungen. Von der gemeinsamen Entwicklung der oben geschilderten, transparenten IVEs sollen letztlich alle Disziplinen profitieren.