逼真的虚拟环境有助于优化许多科学领域的实验

即使在今天,人类还远未完成对于自身机能运行全过程的探索。尤其是大脑的工作原理和感官知觉仍然困扰着研究人员。近期,David Julius 和 Ardem Patapoutian 因发现温度和触觉感受器而获得诺贝尔医学奖。这表明,即使是人体的基本功能也尚未得到充分的探索。

另一个案例是在嘈杂环境的听觉感知。例如在火车站,即使人类的耳朵记录了所有环境的声音,但他们怎么仍可以专注地与另一个人交谈?这个问题属于“听觉感知”范畴,该领域研究大脑解释声音世界的过程。它还包含了复杂声音的感知(这对于处理语音、音乐和环境声音至关重要)以及为此运行的大脑区域。目前,我们很难在受控实验室环境中模拟火车站等嘈杂的环境声,研究人员一直通过虚拟现实技术来支持他们的研究。

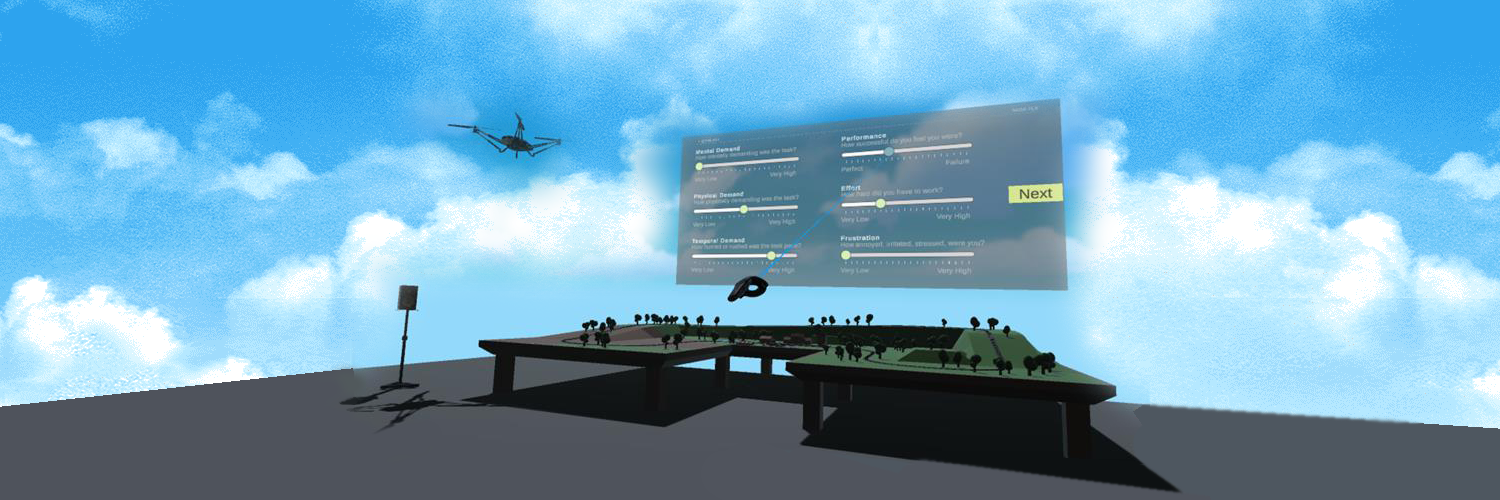

近年来,我们在理解听觉认知过程和能力方面取得了相当大的进展,在实验中使用简单的虚拟环境对研究有着很大的帮助。它们很容易控制,但却往往不太真实。 VR 技术的不断发展使环境模拟变得非常逼真,消除了早期实验室环境的许多限制。例如,有助于理解复杂视听情况听觉感知的交互式虚拟环境 (IVEs)。它们可用于模拟声学上不利的情况,例如文章开头处描述的火车站、嘈杂的教室和拥挤的开放式办公室。

如何评估virtual?

引人入胜的虚拟环境使技术透明化,人们可以自然地与虚拟世界互动。但是如何评估IVEs的质量,哪些参考变量与此相关?在经典的音视频编码中,质量控制相对简单:通常的做法是直接比较编码和非编码信号。用户专注于特定的某个元素(例如声音或图像质量)并在原始信号和他们想要评估的信号之间来回切换。这种方法很容易就会发现差异。但这种方法通常不适用于IVEs的评估。由于这些元素是多模态的,甚至允许在虚拟场景中移动,因此测试人员往往会自动关注多个元素(声音、图像和移动)。这种多模式感官刺激对注意力和质量评估的影响很大。

为了找到并弥补方法论上的差距,德国研究基金会 (DFG) 资助并启动了视听场景的交互式虚拟环境体验质量评估(QoEVAVE)项目。用于调查研究是否可以从人们的行为推断IVEs的质量。该项目以体验质量 (QoE) 研究为基础,并使用VR领域的方法对其进行扩展,为IVEs开发了首个综合QoE框架。目标是说明IVE的认知过程,以及其在特定任务上的认知表现,以作为评估IVE质量的一个特征。

携手推进科学进步

目前,来自爱尔兰根国际音频实验室(AudioLabs)的Emanuël Habets教授和来自伊尔梅瑙工业大学(TU Ilmenau)的Alexander Raake教授正在共同领导QoEVAVE项目的研究。他们的团队正在开发和测试一种评估IVEs质量的方法。这是一个多步骤的程序,评估必须以单模态(一次仅评估一种元素,音频或视频)和多模态(同时评估音频和视频)进行。首先需要设计一个单峰测试程序。为此,工作人员制作了日常生活场景的360度录像和录音。来自伊尔梅瑙工业大学的媒体专业人员负责视频录制,而音频实验室的专家则负责录音(使用 em32 Eigenmike)并对其进行双耳渲染。在这个场景中,主体只能移动他们的头部(3DoF)。由于真实的视频录制和有限的运动可能性,测试人员可以分别专注于音频或视频质量。该项目的终极目标是在一个可以自由移动(6DoF)的虚拟场景中进行评估。在这里值得关注的问题是,测试人员在两个场景中是否对相同的音频质量进行了不同的评价。常见的评估方法(如 MUSHRA测试)并不直接适用于IVEs的评估。爱尔兰根和伊尔梅瑙的研究人员为适应虚拟环境正在推进和调整现有的评估方法。

QoEVAVE是于2021年1月开始的为期3年的DFG优先计划AUDICTIVE(交互式虚拟环境中的听觉认知,http://www.spp2236-audictive.de)的一部分。AUDICTIVE 汇集了众多来自声学、认知心理学和计算机科学/虚拟现实领域的专家。目标是使用交互式虚拟环境更准确地了解人类听觉感知和认知。最终,所有学科都将受益于IVEs的联合开发。